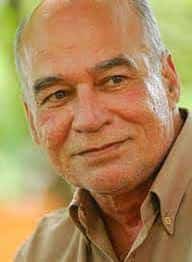

«Aquí tenemos que ser bastante cautos, distinguiendo entre el lenguaje per se y el habla, que es una amalgama, que involucra tanto lenguaje como un sistema sensorial específico utilizado para la externalización del lenguaje.» Noam Chomsky

Entrevista realizada a Noam Chomsky por Amy Brand, directora de la prensa del MIT. Publicado originalmente bajo el titulo «Sobre el lenguaje y la humanidad: en conversación con Noam Chomsky».

Me ha fascinado cómo estructura la mente la información durante todo el tiempo que puedo recordar. De niño, mi actividad favorita de todos los tiempos en la escuela media estaba diagramando frases con sus partes del habla. Tal vez no es sorprendente, entonces, que terminé en el MIT ganando mi doctorado en modelos formales de lenguaje y cognición. Fue allí, a mediados de la década de 1980, donde tuve la tremenda fortuna de tomar varias clases en sintaxis con Noam Chomsky.

Aunque finalmente opté por la trayectoria de la carrera docente, he estado en el MIT durante la mayor parte de mi carrera y he mantenido fiel de muchas maneras a ese enfoque original en cómo el lenguaje transmite información. Diriendo una editorial académica es, después de todo, también sobre el camino del idioma a la información, el texto al conocimiento. También me ha dado la oportunidad de servir como editor de Chomsky. Chomsky y los valores centrales que encarna de una profunda indagación, conciencia e integridad siguen siendo grandes para mí y tantos otros aquí en el MIT, y están bien reflejados en la entrevista que sigue.

Amy Brand: Usted ha tendido a separar su trabajo en el lenguaje de su personalidad política y sus escritos. Pero hay una tensión entre argumentar por la singularidad del Homo sapiens cuando se trata del lenguaje, por un lado, y describiendo el papel humano en el cambio climático y la degradación ambiental, por el otro? Es decir, podríamos estar atados a distancia de otras especies en la forma en que nos comprometimos (o fracasamos en participar) con el medio natural?

Noam Chomsky: El trabajo técnico en sí es en principio bastante separado de los compromisos personales en otras áreas. No hay conexiones lógicas, aunque hay algunas más sutiles e históricas que he discutido ocasionalmente (como han hecho otros) y que podrían ser de cierta importancia.

El Homo sapiens es radicalmente diferente de otras especies de muchas maneras, demasiado obvio para revisar. La posesión del lenguaje es un elemento crucial, con muchas consecuencias. Con cierta justicia, a menudo en el pasado se ha considerado como la característica fundamental definitoria de los humanos modernos, la fuente de la creatividad humana, el enriquecimiento cultural y la estructura social compleja.

En cuanto a la ciudad, a la que te refieres, no la veo. Por supuesto, es concebible que nuestra distancia de otras especies esté relacionada con nuestra raza criminal para destruir el medio ambiente, pero no creo que esa conclusión sea sostenida por el registro histórico. Durante casi toda la historia humana, los seres humanos han vivido prácticamente en armonía con el medio natural, y los grupos indígenas todavía lo hacen, cuando pueden (de hecho, están, en la vanguardia de los esfuerzos para preservar el medio ambiente, en todo el mundo). Las acciones humanas han tenido efectos ambientales; por lo tanto, los grandes mamíferos tendieron a desaparecer a medida que se extendía la actividad humana. Pero no fue hasta la revolución agrícola y más dramáticamente la revolución industrial que el impacto se convirtió en de gran importancia. Y los efectos más grandes y más destructivos son en los últimos años, y encajan demasiado rápido. Las fuentes de la destrucción que está al borde de la catástrofe parecen ser institucionales, no de alguna manera arraigadas en nuestra naturaleza.

A.B.: En un prólogo de un libro sobre el canto del pájaro y el lenguaje, escribiste, con el lingüista computacional Robert Berwick, que el puente entre la investigación de canto de los pájaros y el habla y el lenguaje encaja muy bien con los recientes desarrollos en ciertos hilos del pensamiento linguístico actual. Podrías hablar de eso? Qué clase de visión podría ofrecer el canto de los pájaros en nuestro propio idioma?

N.C.: Aquí tenemos que ser bastante cautos, distinguiendo entre el lenguaje per se y el habla, que es una amalgama, que involucra tanto lenguaje como un sistema sensorial específico utilizado para la externalización del lenguaje. Los dos sistemas no están relacionados en la historia evolutiva; los sistemas sensorial motores estaban en su lugar mucho antes de que el lenguaje (y el Homo sapiens) aparecieran, y apenas han sido influenciados por el lenguaje. El habla también es una forma de externalización, aunque la más común. Podría ser un signo, que se desarrolla entre los sordos mucho de la manera en que lo hace el discurso, o incluso el tacto.

Berwick y yo hemos argumentado (creo plausiblemente, pero no incontrovertiblemente) que el lenguaje, un sistema interno de la mente, es independiente de la externalización y básicamente proporciona expresiones de pensamiento formulado linguísticamente. Como tal, es un sistema de estructura pura, carente de orden lineal y otros arreglos que no forman parte realmente del lenguaje como tal sino que se imponen por los requisitos del sistema articular (señal, que utiliza el espacio visual, explota algunas otras opciones). El lenguaje interno se basa en operaciones recursivas que producen lo que llamamos la Propiedad Básica del lenguaje: generación de una gama infinita de expresiones jerárquicamente estructuradas que se interpretan como pensamientos. El sistema de externalización del lenguaje no tiene operaciones recursivas – es, básicamente, un mapeo determinista que introduce orden lineal y otros arreglos que son requeridos por el sistema de salida.

Birdsong es muy diferente: es un sistema de salida que se basa crucialmente en el orden lineal con muy poca estructura. Hay algunas analogías sugeridas a los niveles de producción, pero mi propio juicio al menos, compartido por mis colegas que hacen un amplio trabajo en el cantáculo, es que si bien los fenómenos son de considerable interés en sí mismos, nos hablan poco sobre el lenguaje humano.

A.B.: Desarrollaste la teoría de la gramática transformadora, la idea de que hay una estructura profunda basada en reglas que sustenta el lenguaje humano, mientras que un estudiante de posgrado en la década de 1950, y publicaste tu primer libro sobre él, «Estructuras sintácticas», en 1957. Cómo se compara hoy el campo de la linguística teórica con el futuro que podría haber imaginado hace 60 años?

N.C.: Irreconocible. En ese momento, la linguística en general era un campo bastante pequeño, y el interés en el trabajo que usted describe estaba prácticamente confinado a RLE [el Laboratorio de Investigación de Electrónica]. Los diarios eran pocos, y apenas estaban abiertos a obras de este tipo. Mi primer libro – La estructura lógica de la teoría linguística – (LSLT) fue presentado al MIT Press en 1955 en la sugerencia de Roman Jakobson. Fue rechazada por los revisores con el comentario bastante sensato de que no parecía encajar en ningún campo conocido (una versión de 1956, con algunas partes omitidas, fue publicada en 1975, cuando el campo estaba bien establecido).

En realidad había una tradición, una bastante rica de hecho, que este trabajo de alguna manera revivió y extendió. Pero en ese momento se desconocía por completo (y todavía lo es).

A finales de los años 50 Morris Halle y yo solicitamos y recibimos rápidamente autorización para establecer un departamento de linguística, que considerábamos una idea bastante salvaje. Los departamentos de linguística eran raros. Por qué debería haber uno en el MIT, de todos los lugares? Y para una especie de linguística casi nadie había oído nunca? Por qué cualquier estudiante se aplicaría a un departamento así? Decidimos intentarlo de todos modos, y sorprendentemente, funcionó. La primera clase resultó ser un grupo notable de estudiantes, todos los cuales pasaron a carreras distinguidas con un trabajo original y emocionante, por lo que ha continuado, hasta el presente. Curiosamente o tal vez no – el mismo patrón se siguió más o menos en otros países, con la empresa generadora de raíz fuera de las principales universidades.

De hecho, nuestro primer estudiante de doctorado precedió al establecimiento del departamento: Robert Lees (un colega de RLE), quien escribió un estudio muy influyente sobre la nominalización turca. Como todavía no había departamento, nuestro amigo Peter Elias, presidente del Departamento de Ingeniería Eléctese del MIT, había presentado el doctorado allí – bastante típico y altamente productivo informalidad del MIT. Debió sorprender a los orgullosos padres leyendo los títulos de las disertaciones en la graduación.

A estas alturas la situación es dramáticamente diferente. Hay departamentos florecientes en todas partes, con importantes contribuciones de Europa, Japón y muchos otros países. Hay muchas revistas, incluyendo MIT Presss Linguistic Inquiry, que acaba de celebrar su 50 aniversario. Se han llevado a cabo estudios de gramática generativa para una amplia gama de lenguajes tipológicamente variados, a un nivel de profundidad y alcance nunca antes imaginables. Se han abierto nuevos dominios de investigación que apenas existían en los años 50. Los estudiantes están explorando preguntas que no podrían haber sido formuladas hace unos años. Y el trabajo teórico ha alcanzado niveles completamente nuevos de profundidad y validación empírica, con muchas nuevas vías prometedoras siendo exploradas.

Morris y yo, en años posteriores, a menudo reflexábamos sobre lo poco que se podía haber previsto, incluso se podía imaginar, cuando empezamos a trabajar juntos a principios de los años 50. Lo que ha ocurrido desde entonces parecía casi mágico.

A.B.: Fue en ese libro de 1957 que usaste tu conocida frase: «Ibiciaciones verdes incoloras duermen furiosamente» – una demostración de cómo una oración puede ser gramaticalmente correcta pero no tiene sentido, señalando así la estructura y la sintaxis como algo primordial e independiente del significado. Un poeta puede objetar la idea de que tal frase no tiene sentido (y tal vez podría describirla como una demostración de lo que el teórico linguista y literario Roman Jakobson llamó la función de lapoética del lenguaje), y un número de personas se han puesto en «injecting» la oración, por así decirlo, con significado. Por qué crees que es eso?

N.C.: Es por no haber comprendido el punto de este y otros ejemplos como este. El punto era refutar las creencias comunes sobre el estado gramatical: que estaba determinado por aproximación estadística a un corpus de material, por marcos formales, por la significación en algún sentido estructuralmente independiente, etc. La frase que usted cita, llámela (1), es claramente gramatical pero viola todos los criterios estándar. Por eso fue inventado como ejemplo. (1) difiere de la frase estructuralmente similar (2) Las nuevas ideas revolucionarias aparecen infrecuentemente (que, a diferencia de (1), tiene un significado literal inmediato) y de (3) ilusionamente dormir ideas verdes incoloras, la lectura original hacia atrás, que difícilmente puede ser pronunciada con prosodia normal. El estatus especial de (1), por supuesto, surge del hecho de que aunque viola todos los criterios entonces estándar para la gramaticalidad, es de la misma forma gramatical que (2), con un significado literal interpretado instantáneamente y en ningún aspecto desviado. Por esa razón, no es difícil construir interpretaciones no literales para (1) (es posible, pero mucho más difícil para (3), carente de la semejanza estructural con expresiones totalmente gramaticales como (2)).

Todo esto se discute en «Sintácticas Estructuras», y mucho más plenamente en LSLT (que incluyó algunos trabajos míos conjuntamente con Pete Elias desarrollando una cuenta de categorización con un sabor teórico de la información que funcionó bastante bien con pequeñas muestras y el cálculo de la mano que era la única opción a principios de los 50, cuando estábamos haciendo este trabajo como estudiantes de posgrado en Harvard).

Al no entender el punto, bastantes personas han ofrecido interpretaciones metafóricas de (1), exactamente en la línea sugerida por la discusión en «Estructuras sintácticas». Menos para (3), aunque incluso eso es posible, con esfuerzo. Es típicamente posible inventar algún tipo de interpretación para casi cualquier secuencia de palabras. La pregunta relevante, para el estudio del lenguaje, es cómo las reglas producen interpretaciones literales (en cuanto a (2)) y secundariamente, cómo otros procesos cognitivos, confiando en parte en la estructura del lenguaje (como en el caso de (1), (3)), pueden proporcionar una gran cantidad de otras interpretaciones.

A.B.: En nuestra entrevista con Steven Pinker en mayo, pedimos sus pensamientos sobre el impacto que la reciente explosión de interés en la IA y el aprendizaje automático podría tener en el campo de la ciencia cognitiva. Pinker dijo que sentía que había una estanqueidad teórica en estos reinos que iba a producir callejones sin salida a menos que estuvieran más estrechamente integrados con el estudio de la cognición. El campo de la ciencia cognitiva que usted ayudó a originarse fue una clara ruptura del conductismo. El énfasis en el impacto de los factores ambientales en el comportamiento sobre factores innatos o hereditario – y el trabajo de B. F. Skinner. Usted ve el crecimiento del aprendizaje automático como algo similar a un retorno al conductismo? Siente que la dirección en la que se está desarrollando el campo de la computación es motivo de preocupación, o podría insufrar nueva vida al estudio de la cognición?

N.C.: A veces se afirma explícitamente, incluso triunfante. En Terrence Sejnowski, reciente, la Revolución de Aprendizaje Profundo, por ejemplo, proclamando que Skinner tenía razón. Un malentendido bastante serio de Skinner, y de los logros de la Revolución, creo.

Hay algunas preguntas obvias que plantear sobre los proyectos de aprendizaje de máquinas. Tomemos un ejemplo típico, el Parser de Google. La primera pregunta a hacer es: para qué se trata? Si el objetivo es crear un dispositivo útil, una forma estrecha de ingeniería, no hay nada más que decir.

Supongamos que el objetivo es la ciencia, es decir, aprender algo sobre el mundo, en este caso, sobre la cognición – específicamente sobre cómo los humanos procesan las sentencias. Luego surgen otras preguntas. La pregunta más poco interesante, y la única que se plantea, es lo bien que lo hace el programa, digamos, al analizar el corpus de Wall Street Journal.

Digamos que tiene 95 por ciento de éxito, como se proclama en Google PR, que declara que el problema de análisis se resuelve básicamente y los científicos pueden pasar a otra cosa. Qué significa eso exactamente? Recordemos que ahora estamos considerando que esto es parte de la ciencia. Cada frase del corpus puede ser considerada como la respuesta a una pregunta planteada por el experimento: Eres una frase gramatical de inglés con tal estructura? La respuesta es: Sí (generalmente). A continuación, planteamos la cuestión que se plantearía en cualquier ámbito de la ciencia. Qué interés hay en una teoría, o método, que obtiene la respuesta correcta en el 95 por ciento de los experimentos elegidos al azar, realizados sin propósito? Respuesta: Prácticamente no hay interés en absoluto. Lo que es de interés son las respuestas a experimentos críticos impulsados por la teoría, diseñados para responder a alguna pregunta significativa.

Así que si esto es «ciencia», es de algún tipo desconocido.

La siguiente pregunta es si los métodos utilizados son similares a los utilizados por los humanos. La respuesta es: radicalmente no. Una vez más, algún tipo desconocido de ciencia.

También hay otra cuestión, al parecer nunca planteada. Qué tan bien trabaja el Parser en lenguajes imposibles, aquellos que violan los principios universales del lenguaje? Tenga en cuenta que el éxito en el análisis de tales sistemas cuenta como fracaso, si los objetivos son ciencia. Aunque no se ha intentado que yo sepa, la respuesta es casi seguro que el éxito sería alto, en algunos casos incluso más alto (mucho menos ensayos de entrenamiento, por ejemplo) que para los lenguajes humanos, particularmente para los sistemas diseñados para utilizar propiedades elementales de la computación que están prohibido en principio para los lenguajes humanos (utilizando el orden lineal, por ejemplo). A estas alturas se conoce mucho sobre los lenguajes imposibles, incluyendo algunas evidencias psicolinguísticas y neurolinguísticas sobre cómo los humanos manejan tales sistemas, si acaso, como rompecabezas, no idiomas.

En resumen, en casi todos los aspectos relevantes es difícil ver cómo este trabajo hace cualquier tipo de contribución a la ciencia, específicamente a la ciencia cognitiva, cualquier valor que pueda tener para construir dispositivos útiles o para explorar las propiedades de los procesos computacionales que se emplean.

Podría argumentarse que la última pregunta está mal formulada porque no hay lenguaje imposible: cualquier colección de secuencias de palabras elegida arbitrariamente es tanto de un lenguaje como cualquier otra. Incluso aparte de una amplia evidencia de lo contrario, la afirmación debe ser rechazada por razones lógicas elementales: si fuera verdad, ningún lenguaje podría aprenderse, trivialmente. Sin embargo, algunas de esas creencias se mantuvieron ampliamente en el apodo del conductismo y el estructuralismo, a veces bastante explícitamente, en lo que se llamó «la tesis jactaniana» de que los idiomas pueden diferir una de otras de maneras arbitrarias, y cada uno debe ser estudiado sin preconcepciones (reclamaciones similares fueron expresadas por los biólogos con respecto a la variedad de organismos). Ideas similares están al menos implícitas en algunas de las literaturas de aprendizaje automático. Sin embargo, está claro que las afirmaciones no pueden ser seriamente entretenidas, y ahora se sabe que son incorrectas (también en lo que respecta a los organismos).

Otra palabra puede ser útil en la noción de experimento crítico, es decir, experimento basado en la teoría diseñado para responder a alguna pregunta de interés linguístico. Con respecto a estos, los sistemas de análisis mecánicos altamente avanzados funcionan bastante mal, como ha demostrado eficazmente el científico cognitivo computacional Sandiway Fong. Y eso es lo que importa a la ciencia al menos, no sólo igualar los resultados de experimentos arbitrarios sin ningún propósito (como la simulación, o el parsing algo de corpus). Los experimentos más interesantes tienen que ver con construcciones linguísticas exóticas que son raras en el habla normal, pero que la gente entiende instantáneamente junto con todas las condiciones curiosas que satisfacen. A lo largo de los años se han descubierto bastantes. Sus propiedades son particularmente esclarecedoras porque sacan a la luz los principios no apreciados que hacen posible la adquisición del lenguaje – y aunque no voy a continuar el asunto aquí, la investigación de la adquisición del lenguaje infantil y los cuidadosos estudios estadísticos del material linguístico disponible para el niño (particularmente por Charles Yang) revelan que la noción «exótico» se extiende muy ampliamente para la experiencia de los infantes.

A.B.: Permaneáis tan activo como siempre, en más de un frente, colaborando con colegas de otros campos como la informática y la neurociencia en una serie de artículos en los últimos años, por ejemplo. En qué estás trabajando?

N.C.: Vale la pena volver brevemente al principio. Comencé a experimentar con gramáticas generativas como pasatiempo privado a finales de los años 40. Mi interés estaba en parte en tratar de dar cuenta de los datos en una gramática generativa basada en reglas explícita, pero aún más en explorar el tema de la simplicidad de la gramática, el programa más corto, un problema no trivial, sólo parcialmente solucionable por el cálculo manual debido a la complejidad de los sistemas de reglas profundamente ordenados. Cuando llegué a Harvard poco después, conocí a Morris Halle y Eric Lenneberg. Rápidamente nos hicimos amigos cercanos, en parte debido al escepticismo compartido sobre las doctrinas de la ciencia conductual prevalecientes. Esos intereses compartidos pronto condujeron a lo que llegó a llamarse más tarde el programa de «biolinguística», el estudio de la gramática generativa como un rasgo biológico del organismo (Eric pasó a fundar el campo contemporáneo de la biología del lenguaje a través de su obra ahora clásica).

Dentro del marco biolinguístico, está de inmediato claro que el «santo grial» sería explicaciones de las propiedades fundamentales del lenguaje sobre la base de gramáticas generadoras de principios que cumplen las condiciones gemelas de aprenciabilidad y evolutividad. Ese es el criterio para una explicación genuina. Pero ese gol estaba muy fuera de su alcance.

La tarea inmediata era tratar de dar sentido a la enorme cantidad de nuevos datos, y problemas desconcertantes, que se acumulaban rápidamente tan pronto como se hacían los primeros esfuerzos para construir gramáticas generativas. Hacerlo parecía requerir mecanismos bastante complejos. No voy a revisar la historia desde entonces, pero su empuje básico ha sido el esfuerzo de mostrar que las suposiciones más simples y de principios pueden producir los mismos o mejores resultados empíricos en un amplio rango.

A principios de los 90, nos pareció que ahora era posible morder la bala: adoptar los mecanismos computacionales más simples que al menos podrían ceder la Propiedad Básica y tratar de demostrar que las propiedades fundamentales del lenguaje se pueden explicar en esos términos en términos de lo que se ha llamado la tesis minimalista (SMT). A estas alturas, creo, ha habido un progreso considerable en este empeño, con las primeras explicaciones genuinas de importantes propiedades universales del lenguaje que cumplen plausiblemente las condiciones gemelas.

La tarea por delante tiene varias partes. Una tarea primordial es determinar en qué medida el SMT puede abarcar principios fundamentales de lenguaje que han salido a la luz en la investigación de los últimos años, y tratar los experimentos críticos, aquellos que son particularmente reveladores con respecto a los principios que entran en el funcionamiento de la facultad de idiomas y que explican la adquisición de un idioma.

Una segunda tarea es distinguir entre principios específicos del lenguaje – específico de la estructura innata de la facultad de idiomas – y otros principios que son más generales. Particularmente esclarecedor en este sentido son los principios de la eficiencia computacional – no sorprendente para un sistema computacional como el lenguaje. De particular interés son los principios computacionales específicos de los sistemas con una capacidad limitada de recursos a corto plazo, categoría que recientemente se ha demostrado que tiene consecuencias empíricas críticas. Otra tarea es afinar estos principios para incluir aquellos que juegan un papel en una explicación genuina, al tiempo que excluyen a otros que se ven superficialmente similares pero que pueden demostrarse que son ilegítimos tanto empírica como conceptualmente.

Un trabajo bastante interesante está procesionando en todas estas áreas, y el tiempo parece estar listo para una revisión completa de los acontecimientos que, creo, proporcionan una etapa bastante nueva y emocionante en un antiguo campo de investigación.

En resumen, por primera vez pienso que el Santo Grial está al menos en la vista en algunas áreas centrales, tal vez incluso al alcance de la mano. Ese es el tema principal del trabajo en el que se ha dedicado recientemente y espero poder armar pronto.

A.B.: Hace poco celebraste junto con un gran cuerpo de amigos y colegas aquí en el campus del MIT. Tales hitos son, por supuesto, motivo de reflexión, incluso mientras uno mira hacia adelante. Mirando tu trabajo hasta la fecha, lo que dirías ha sido tu contribución teórica más significativa al campo de la linguística?

N.C.: Abrr a partir de nuevos tipos de preguntas y temas para la investigación.

A.B.: Una pregunta muy amplia, pero tal vez una que habla de los tiempos en los que vivimos ahora: Qué consideras estos días como motivo de optimismo?

N.C.: Varios puntos. En primer lugar, los tiempos en los que vivimos son extremadamente peligrosos, de alguna manera más que nunca en la historia de la humanidad, que esencialmente llegará a su fin en cualquier forma reconocible si no nos ocupamos eficazmente de las crecientes amenazas de la guerra nuclear y de la catástrofe medioambiental. Eso requiere revertir el curso de Estados Unidos en el desmantelamiento de los acuerdos de control de armas y proceder -junto con Rusia- para desarrollar sistemas de armas cada vez más letales y desestabilizadores; y no sólo negarse a unirse al mundo en tratar de hacer algo sobre la severa crisis ambiental, sino incluso a la agresiva búsqueda de escalar la amenaza, una forma de criminalidad sin literalmente ningún antecedente histórico.

No es fácil, pero se puede hacer.

Ha habido otras crisis graves en la historia de la humanidad, aunque no a esta escala. Tengo la edad suficiente para recordar los días en que parecía que la propagación del fascismo era inexorable y no me refiero a lo que hoy se conoce como fascismo, sino algo incomparablemente más horrible. Pero fue superado.

Hay formas muy impresionantes de activismo y compromiso que tienen lugar, principalmente entre los más jóvenes. Eso es muy alentador.

En última instancia, siempre tenemos dos opciones: Podemos elegir descender al pesimismo y la apatía, suponiendo que no se pueda hacer nada, y ayudando a asegurar que lo peor suceda. O podemos captar las oportunidades que existen y ellas y las persiguen en la medida en que podamos, ayudando así a contribuir a un mundo mejor.

No es una elección muy difícil.

https://www.bloghemia.com/2024/10/sobre-el-lenguaje-y-la-humanidad-por.html