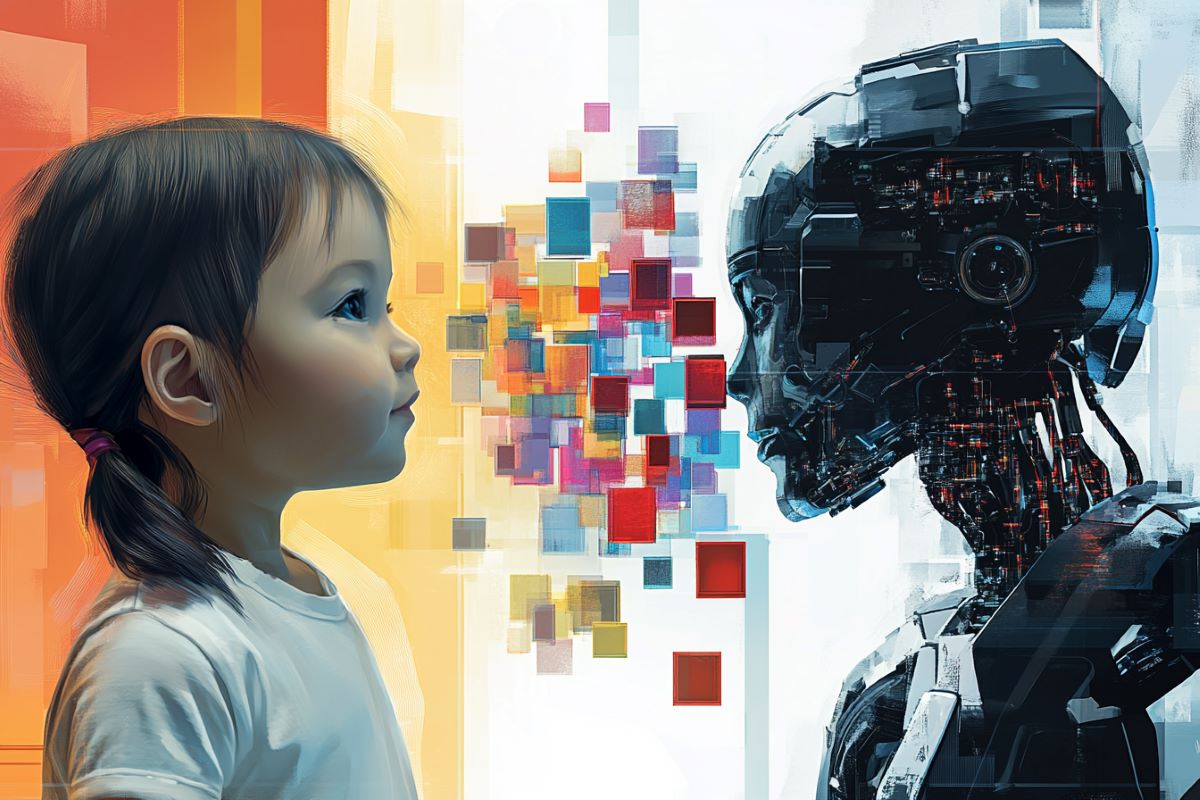

Resumen: Un nuevo modelo de IA, basado en el marco PV-RNN, aprende a generalizar el lenguaje y las acciones de una manera similar a la de los niños pequeños, integrando la visión, la propiocepción y las instrucciones del lenguaje. A diferencia de los grandes modelos de lenguaje (LLM, por sus siglas en inglés) que dependen de grandes conjuntos de datos, este sistema utiliza interacciones corporizadas para lograr la composicionalidad y requiere menos datos y potencia computacional.

Los investigadores descubrieron que el diseño modular y transparente de la IA es útil para estudiar cómo los humanos adquieren habilidades cognitivas, como la combinación del lenguaje y las acciones. El modelo ofrece información sobre la neurociencia del desarrollo y podría conducir a una IA más segura y ética al basar el aprendizaje en el comportamiento y en procesos transparentes de toma de decisiones.

Datos clave:

- Aprendizaje similar al de un niño pequeño: la IA aprende la composición integrando entradas sensoriales, lenguaje y acciones.

- Diseño transparente: Su arquitectura permite a los investigadores estudiar las vías internas de toma de decisiones.

- Beneficios prácticos: Requiere menos datos que los LLM y resalta el desarrollo de IA ética e incorporada.

Fuente: OIST

Los humanos somos expertos en generalizar. Si le enseñas a un niño pequeño a identificar el color rojo mostrándole una pelota roja, un camión rojo y una rosa roja, lo más probable es que identifique correctamente el color de un tomate, incluso si es la primera vez que ve uno.

Un hito importante en el aprendizaje de la generalización es la composicionalidad: la capacidad de componer y descomponer un todo en partes reutilizables, como el color rojo de un objeto. Cómo adquirimos esta capacidad es una pregunta clave en la neurociencia del desarrollo y en la investigación de la IA.

Las primeras redes neuronales, que luego evolucionaron hasta convertirse en los grandes modelos de lenguaje (LLM) que revolucionaron nuestra sociedad, se desarrollaron para estudiar cómo se procesa la información en nuestro cerebro.

Irónicamente, a medida que estos modelos se volvieron más sofisticados, las vías de procesamiento de información dentro de ellos también se volvieron cada vez más opacas, y hoy algunos modelos tienen billones de parámetros ajustables.

Pero ahora, miembros de la Unidad de Investigación en Neurorobótica Cognitiva del Instituto de Ciencia y Tecnología de Okinawa (OIST) han creado un modelo de inteligencia encarnada con una arquitectura novedosa que permite a los investigadores acceder a los diversos estados internos de la red neuronal y que parece aprender a generalizar de la misma manera que lo hacen los niños.

Sus hallazgos ahora han sido publicados en Science Robotics .

“Este artículo demuestra un posible mecanismo para que las redes neuronales logren composicionalidad”, afirma el Dr. Prasanna Vijayaraghavan, primer autor del estudio.

“Nuestro modelo logra esto no mediante inferencias basadas en grandes conjuntos de datos, sino combinando el lenguaje con la visión, la propiocepción, la memoria de trabajo y la atención, tal como lo hacen los niños pequeños”.

Perfectamente imperfecto

Los LLM, basados en una arquitectura de red de transformadores, aprenden la relación estadística entre las palabras que aparecen en oraciones a partir de grandes cantidades de datos de texto. Básicamente, tienen acceso a todas las palabras en todos los contextos imaginables y, a partir de este conocimiento, predicen la respuesta más probable a una pregunta dada.

Por el contrario, el nuevo modelo se basa en un marco PV-RNN (Predictive coding inspired, Variational Recurrent Neural Network), entrenado a través de interacciones corporizadas que integran tres entradas simultáneas relacionadas con diferentes sentidos: la visión, con un video de un brazo robótico moviendo bloques de colores; la propiocepción, el sentido del movimiento de nuestras extremidades, con los ángulos de las articulaciones del brazo robótico mientras se mueve; y una instrucción de lenguaje como «pon rojo sobre azul».

Luego, se le pide al modelo que genere una predicción visual y los ángulos articulares correspondientes en respuesta a una instrucción de lenguaje, o una instrucción de lenguaje en respuesta a una entrada sensorial.

El sistema está inspirado en el Principio de Energía Libre, que sugiere que nuestro cerebro predice continuamente las entradas sensoriales basadas en experiencias pasadas y toma medidas para minimizar la diferencia entre la predicción y la observación.

Esta diferencia, cuantificada como «energía libre», es una medida de incertidumbre y, al minimizar la energía libre, nuestro cerebro mantiene un estado estable.

Junto con una memoria de trabajo y una capacidad de atención limitadas, la IA refleja las limitaciones cognitivas humanas, lo que la obliga a procesar la información y actualizar su predicción en secuencia en lugar de hacerlo todo a la vez, como lo hacen los LLM.

Al estudiar el flujo de información dentro del modelo, los investigadores pueden obtener conocimientos sobre cómo integra las distintas entradas para generar sus acciones simuladas.

Gracias a esta arquitectura modular, los investigadores han aprendido más sobre cómo los bebés pueden desarrollar la capacidad de composición. Como relata el Dr. Vijayaraghavan: «Descubrimos que cuanto más expuesto está el modelo a la misma palabra en diferentes contextos, mejor aprende esa palabra.

Esto refleja la vida real, donde un niño pequeño aprenderá el concepto del color rojo mucho más rápido si interactúa con varios objetos rojos de diferentes maneras, en lugar de simplemente empujar un camión rojo en múltiples ocasiones”.

Abriendo la caja negra

“Nuestro modelo requiere un conjunto de entrenamiento significativamente más pequeño y mucho menos poder computacional para lograr la composicionalidad. Comete más errores que los LLM, pero son similares a los que cometen los humanos”, afirma el Dr. Vijayaraghavan.

Es exactamente esta característica la que hace que el modelo sea tan útil para los científicos cognitivos, así como para los investigadores de IA que intentan mapear los procesos de toma de decisiones de sus modelos.

Si bien tiene un propósito diferente al de los LLM que se utilizan actualmente y, por lo tanto, no se puede comparar significativamente en términos de efectividad, el PV-RNN muestra, no obstante, cómo se pueden organizar las redes neuronales para ofrecer una mayor comprensión de sus vías de procesamiento de información: su arquitectura relativamente superficial permite a los investigadores visualizar el estado latente de la red: la representación interna en evolución de la información retenida del pasado y utilizada en las predicciones presentes.

El modelo también aborda el problema de la pobreza de estímulo, que postula que el aporte lingüístico disponible para los niños es insuficiente para explicar su rápida adquisición del lenguaje.

A pesar de tener un conjunto de datos muy limitado, especialmente en comparación con los LLM, el modelo aún logra composicionalidad, lo que sugiere que fundamentar el lenguaje en el comportamiento puede ser un catalizador importante para la impresionante capacidad de aprendizaje del lenguaje de los niños.

Este aprendizaje incorporado podría además mostrar el camino hacia una IA más segura y ética en el futuro, tanto al mejorar la transparencia como al ser capaz de comprender mejor los efectos de sus acciones.

Aprender la palabra “sufrimiento” desde una perspectiva puramente lingüística, como lo hacen los LLM, tendría menos peso emocional que para un PV-RNN, que aprende el significado a través de experiencias corporales junto con el lenguaje.

“Seguimos trabajando para mejorar las capacidades de este modelo y lo estamos utilizando para explorar varios dominios de la neurociencia del desarrollo.

“Estamos entusiasmados por ver qué futuros conocimientos sobre el desarrollo cognitivo y los procesos de aprendizaje del lenguaje podemos descubrir”, dice el profesor Jun Tani, jefe de la unidad de investigación y autor principal del artículo.

Cómo adquirimos la inteligencia necesaria para crear nuestra sociedad es una de las grandes preguntas de la ciencia. Aunque el PV-RNN no ha dado respuesta a esta pregunta, abre nuevas vías de investigación sobre cómo se procesa la información en nuestro cerebro.

“Al observar cómo el modelo aprende a combinar lenguaje y acción”, resume el Dr. Vijayaraghavan, “obtenemos conocimientos sobre los procesos fundamentales que subyacen a la cognición humana.

“Ya nos ha enseñado mucho sobre la composicionalidad en la adquisición del lenguaje y muestra el potencial para modelos más eficientes, transparentes y seguros”.

Acerca de esta noticia de investigación sobre inteligencia artificial y aprendizaje

Autor: Jun Tani

Fuente: OIST

Contacto: Jun Tani – OIST

Imagen: La imagen se atribuye a Neuroscience News

Investigación original: acceso cerrado.

“ Desarrollo de la composicionalidad a través del aprendizaje interactivo del lenguaje y la acción de los robots ” por Prasanna Vijayaraghavan et al. Science Robotics

Abstracto

Desarrollo de la composicionalidad a través del aprendizaje interactivo del lenguaje y la acción de los robots

Los seres humanos son expertos en aplicar conductas aprendidas a situaciones no aprendidas. Un componente crucial de esta conducta de generalización es nuestra capacidad de componer o descomponer un todo en partes reutilizables, un atributo conocido como composicionalidad.

Una de las preguntas fundamentales en robótica se refiere a esta característica: ¿cómo se puede desarrollar la composicionalidad lingüística concomitantemente con las habilidades sensoriomotoras a través del aprendizaje asociativo, particularmente cuando los individuos sólo aprenden composiciones lingüísticas parciales y sus patrones sensoriomotores correspondientes?

Para abordar esta cuestión, proponemos un modelo de red neuronal inspirado en el cerebro que integra la visión, la propiocepción y el lenguaje en un marco de codificación predictiva e inferencia activa sobre la base del principio de energía libre.

La eficacia y las capacidades de este modelo se evaluaron mediante varios experimentos de simulación realizados con un brazo robótico.

Nuestros resultados muestran que la generalización en el aprendizaje de composiciones verbo-sustantivo no aprendidas mejora significativamente cuando se incrementan las variaciones de entrenamiento de la composición de la tarea.

Atribuimos esto a que las estructuras compositivas autoorganizadas en el espacio de estados latentes lingüísticos están influenciadas sustancialmente por el aprendizaje sensoriomotor.

Los estudios de ablación muestran que la atención visual y la memoria de trabajo son esenciales para generar con precisión secuencias visomotoras para lograr objetivos representados lingüísticamente.

Estos conocimientos amplían nuestra comprensión de los mecanismos que subyacen al desarrollo de la composicionalidad a través de interacciones de la experiencia lingüística y sensoriomotora.